LSIS

UMR CNRSLab.

Sciences de l'Information et des Systèmes

|

|

|

|

Ecole

Recherche Multimodale d’Information

Techniques

& Sciences

*** voir EDITION 2007 et nouveautes sur http://glotin.univ-tln.fr/ERMITES ***

![]() ERMITES

2006

ERMITES

2006![]()

avec

les soutiens du LSIS, du département d'informatique de l'UFRST

USTV,

et de l'Association

Francophone de la Commmunication Parlée (AFCP).

4

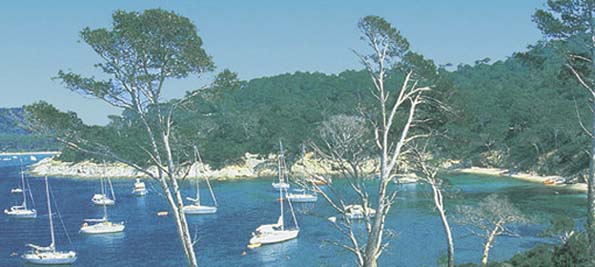

- 6 septembre 2006 - Presqu'île de Giens – Var

Proceedings ERMITES 2006 (.pdf, 20MO, 200 pages)

La recherche d’information, sur le web notamment, est de plus en plus complexe et hasardeuse compte tenu du volume sans cesse croissant des informations disponibles et de leur nature multimodale (textes, images, sons, vidéos…). C’est afin :

- d’analyser les dernières avancées, théoriques et pratiques, des Systèmes Robustes de Recherche d’Information Multimodale (SRIM), couplant textes, images, sons ou vidéos,

- de sensibiliser les jeunes scientifiques au vaste champ scientifique nécessaire à l’élaboration de SRIM et au problème de leur fiabilité,

que nous avons décidé d’organiser à la presqu’île de Giens dans le Var du 4 au 6 septembre, l’Ecole Recherche Multimodale d’Information: Techniques & Sciences (ERMITES) avec le concours de l’Association Francophone de la Communication Parlée (AFCP), du Laboratoire des Sciences de l’Information et des Systèmes (LSIS) et de l’Université du Sud Toulon-Var.

Le recueil d'ERMITES 2006 (200 pages .pdf ci-dessus), réunit les présentations faites à ERMITES qui portent sur les thèmes suivants : les théories de l’information, du signal, des processus aléatoires et de l’apprentissage automatique ; l’analyse de scène (audio et vidéo) ; l’intelligence artificielle ; le traitement automatique du langage et de la parole ; les sciences cognitives et la neurophysiologie de la perception ; la recherche d’information textuelle. Un des objectifs d’ERMITES est que ses participants ne voient plus d’antagonismes entre ces diverses disciplines qui se lieront de plus en plus pour générer des SRIM efficaces. Nous tenons à remercier tous ceux qui ont contribué à la tenue d’ERMITES 2006 : les intervenants, les participants ainsi que le LSIS, l’AFCP, et l’USTV pour leur soutien matériel et financier.

Les organisateurs, Hervé Glotin et Jacques Le Maitre

SOMMAIRE

Samy Bengio (IDIAP), Apprentissage pour le Traitement de Séquences Multimodales et

Recherche d'Information dans les Séquences Multimodales ... page 5

Patrick Gallinari (LIP6), Méthodes statistiques pour l'apprentissage de structure ... page 61

Pascale Giraudet (USTV), Neurophysiologie de la Vision : des Traits au Sens ... page 91

Patrick Mulhem (CLIPS), Indexation & Recherche Sémantique d'Images ... page 99

H. Glotin (LSIS), Recherche Robuste d'Information dans des Scènes Audiovisuelle ... page109

Jérôme Farinas (IRIT), Identification & Classification Automatique de Langues ... page127

J.-F. Bonastre (LIA), Reconnaissance du Locuteur & Indexation de Documents Audio ... page 133

G. Gravier (IRISA), Reconnaissance Automatique de la Parole ... page 141

P. Joly (IRIT), Segmentation & Thématisation de Séquences Vidéo, Similarité de contenu visuel ... page 157

G. Gravier & P. Gros (IRISA), Structuration Multimodale de Vidéos de Sports ... page 169

J. Le Maitre (LSIS), Recherche d'Information Textuelle dans des Documents XML ... page 175

Détails thématiques et intervenants (T: Texte, I: Image, S: Son, V: Vidéo)

|

Tuteurs |

T |

I |

S |

V |

Titres des interventions |

|

Samy

Bengio |

|

|

|

|

Algorithmes d'Apprentissage pour le Traitement de Séquences Multimodales. |

|

Jean-François

Bonastre |

|

|

|

|

Reconnaissance du locuteur et indexation de documents audio. Illustration sur des campagnes d'évaluations. |

|

Jérôme

Farinas |

|

|

|

|

Identification et classification automatique de langues et dialectes oraux. Illustration des analyses prosodiques, phonologiques et phonotactiques. |

|

Patrick

Gallinari |

|

|

|

|

Méthodes en Intelligence Artificielle pour le Traitement Automatique du Langage et la recherche par le contenu de documents visuels. |

|

Pascale

Giraudet |

|

|

|

|

Bases neurophysiologiques de l'analyse de scène. Illustration des systèmes de perception en vision, audition, et olfaction. |

|

Hervé

Glotin |

|

|

|

|

Systèmes

robustes de recherche d'information audiovisuels. |

|

Guillaume

Gravier |

|

|

|

|

a)

Thématisation de séquences audiovisuelles,

reconnaissance automatique de la parole. Illustration sur des

émissions sportives et journalistiques. |

|

Philippe

Joly |

|

|

|

|

Segmentation et thèmatisation séquences vidéo, analyse des traits visuels. Discussion sur les mesures de distance dans l'espace visuel. |

|

Jacques

Le Maitre |

|

|

|

|

Recherche d'information dans des documents XML. Extensions des langages XPath ou XQuery. |

|

Philippe

Mulhem |

|

|

|

|

Systèmes sémantiques images (indexation et recherche). Survol des approches non-symboliques et symboliques sur les images fixes. |

|

Répartition |

5 |

8 |

6 |

7 |

|

Résumé

des interventions :

Algorithmes

d'Apprentissage pour le Traitement de Séquences Multimodales

(Samy Bengio)

Avec la prolifération de petites unités

d'enregistrements (caméras, microphones, EEGs, etc) de plus en

plus abordables, efficaces et rapides, il est de plus en plus

important de déveloper des algorithmes efficaces de traitement

statistique de séquences multimodales, pour des applications

variées telles que la reconnaissance de la parole, le suivi de

personnes, l'analyse de scènes, etc.

Le cours commencera

par une introduction générale à la théorie

de l'apprentissage statistique, puis se concentrera sur son

application au traitement de séquences, par l'exposition de

plusieurs modèles (et de leur algorithme d'apprentissage

associé) de complexité croissante, incluant les

mixtures de Gaussiennes, les modèles de Markov caches, les

modèles de Markov à couches, les modèles de

Markov asynchrones, et quelques modèles graphiques plus récent

(et sans nom particulier).

Plusieurs applications avec des données

réelles seront présentées dans ce cadre-là,

incluant notamment la reconnaissance audio-visuelle de la parole, la

reconnaissance audio-visuelle du locuteur, mais surtout l'analyse du

contenu de réunions de travail, l'analyse de l'influence des

participants d'une activité sur les resultats du groupe,

etc.

Reconnaissance du locuteur et indexation

(Jean-Francois Bonastre)

Ce cours présente les bases de

la reconnaissance du locuteur et de l'indexation selon le locuteur.

Après une introduction au domaine, présentant les

informations spécifiques du locuteur et un panorama des

méthodes utilisées, l'approche statistique est décrite.

Elle regroupe les modélisations de type GMM et HMM,

l'apprentissage des modèles, les mesures de similarités

et les techniques de normalisation couramment utilisées. Les

techniques utilisées en indexation sont également

présentées. Des exemples basés sur le logiciel

"open source" ALIZE/LIA_SpkDet/LIA_Seg permettent

d'illustrer la mise en oeuvre de ces techniques. Le contexte

expérimental des campagnes d'évaluations fait l'objet

de la deuxième partie du cours. La dernière partie du

cours montre une généralisation des éléments

présentés à la recherche et à la

caractérisation de différents événements

sonores.

Traitement automatique de la parole et

identification automatique des langues (Jérôme

Farinas)

L'identification automatique des langues est une

problématique du traitement automatique de la parole dont le

but est de parvenir à discriminer la langue parlée dans

un échantillon sonore. L'analyse linguistique du problème

met en évidence que les sources d'informations utilisables se

situent principalement aux niveaux : - acoustique (la

répartitions des différents sons et leur fréquence

d'apparition) - phonotactique (l'enchaînement des sons entre

eux) - prosodique (l'intonation et le rythme). Après avoir

présenté les différentes caractéristiques

et réalisations de ces sources d'informations dans un cadre

multilingue, les méthodes de modélisation automatiques

adaptées seront présentées : réseau

de neurones, méthodes génératives (modélisation

du langage, GMM, HMM), méthodes discriminatives (SVM). La

problématique de la fusion sera ensuite abordée et

différentes stratégies seront passées en revue :

pondérations arithmétiques, modélisation

gaussienne, théorie de l'incertain (théorie des

probabilités, théorie des possibilités, théorie

de l'évidence). Nous verrons ensuite comment ces différentes

approches pourront être généralisées à

d'autres domaines du traitement automatique que l'identification

automatique des langues et présenterons des applications dans

le cadre de la recherche d'information multimédia.

Méthodes

IA pour le TAL et CBIR (Patrick Gallinari)

Les méthodes

développées en Intelligence Artificielle arrivent à

maturité pour être appliquées à

l'extraction de l'information de texte et images brutes. Les méthodes

exposées sont variées, des réseaux bayésiens

pour le traitement automatique du langage à l'analyse de

contenu d'images. Elles sont notamment présentées au

travers de projets fédérateurs en RI

multimodale.

Bases neurophysiologiques de l'analyse de

scène (Pascale Giraudet)

Cet exposé a pour but

de donner quelques connaissances biologiques susceptibles

d'intéresser les chercheurs en analyse de scène

computationnelle. Nous résumons les grands principes de la

réception, du codage et du traitement de l'information

sensorielle par le système nerveux humain pour les modalités

visuelle, auditive et olfactive. Nous aborderons les principes des

codages standards des traits visuels et auditifs, voire les

modélisations telles que rétines ou nez

artificiels.

Systèmes robustes de recherche

d'information audiovisuels (Hervé Glotin)

Les Systèmes

de Recherche d'Information (SRI) par contenu sur les médias

sonores et visuels sont dégradés en pratique lors de

leur modèlisation ou de leur usage, par des bruits additifs ou

convolutifs, des segmentations ou étiquetages imprécis

des élements cibles ou encore l'usage de traits inadaptés

aux concepts traités. Cet exposé présente des

algorithmes SRI robustes à ces perturbations sur de la parole

et des signaux bio-acoustiques (a) et des images fixes (b).

a)

Nous traitons de la reconnaissance de la parole robuste en présence

de bruits ou de paroles simultanées sur enregistrements audio

ou audio-visuels, notamment par analyse temps-fréquence ou

modèles HMM pondérés. Une autre application en

recherche d'information en bio-acoustique est présentées

: le "tracking" de cétacés (cachalot

plongeant à moins de 1500 mètres), par analyse de leurs

émissions sonores au large des Bahamas, avec les données

du centre Atlantique de surveillance sous-marine. Nous insisterons

sur l'aspect robuste et temps réel de cette application et la

similarité des résultats avec les systèmes

d'interprétation acoustique des laboratoires de la marine des

Etats Unis d'Amérique.

b) Nous traitons des SRI robustes

sur des images pour des concepts plus ou moins abstraits et des bases

d'images imprécisement étiquetées et mal

segmentées, comme le WEB. Après un rappel sur l'ACP

(inefficace dans ce cas), nous montrons comment approximer le critère

de Fisher pour selectionner automatiquement les traits optimaux pour

chaque concept. Les démonstrations sont réalisées

sur les traits de couleurs, formes, et textures gaussiennes ou

ridgelet, et leur héterogénéité; elles

montrent un gain significatif de rappel (+60%) avec une réduction

par 10 de l'espace visuel. Une autre application est présentés

sur l'auto-annotation d'images fixes, notamment du

WEB.

Thèmatisation de séquences vidéo

(Guillaume Gravier, avec le concours de Patrick Gros)

a)

Analyse de documents sonores : présentation plus axée

monomédia/monomodale sur l'analyse du contenu sonore,

développement des aspects reconnaissance de parole et

couplages TALN/RAP, avec aspects de détection et suivi de

classes sonores (parole, musique, applaudissements, locuteurs,

etc.).

Analyse multimodale de séquence vidéos :

présentation de méthodes d'analyse multimodale de

séquences vidéo pour leur structuration. Les techniques

RAP AV, MMC (MMC multiflux, modèles de segments multiflux)

dans un cadre multimédia pour l'analyse de vidéos.

Illustration avec les projets RIAM FERIA.

b) Couplage entre médias

et bases de données : beaucoup de progrès on été

faits en matière d'indexation efficace de descripteurs

d'images par l'emploi d'algorithmes de recherche

approximative.

Similarité de contenus visuels

(Philippe Joly)

L'exposé se structurera en trois

parties : une présentation introductive de caractéristiques

discriminantes de contenus vidéos évoqués dans

l'état de l'art pour décrire la couleur, la texture, la

forme, le mouvement, etc ; puis des techniques de type "fusion",

visant à projeter ces caractéristiques dans un espace

commun dans lequel une distance peut être évaluée

entre les signatures ainsi obtenues; et enfin la présentation

meme de ces distances. Les propriétés de ces signatures

seront discutées en fonction de leur discriminance, leur

compacités, leur invariance, leur robustesse, leur

utilisabilité, leur aptitude à l'échelonnabilité,

et leur interprétabilité. Les propriétés

des distances feront également l'objet d'une discussion en

regard des contraintes imposées par la mise en oeuvre d'un

système de recherche d'informations.

Interrogation

de documents XML tenant compte de leur contenu et de leur structure

(Jacques Le Maitre)

L'exposé rappelle tout d'abord les

principes de l'indexation textuelle : indexation des nœuds d'un

document XML vs indexation globale du document avec une approche

modèle vectoriel. Puis nous présentons l'interrogation

par extensions des langages XPath et XQuery : XQuery Full Text, NEXI,

XIRQL...Nous exposerons enfin le problème de l'indexation

textuelle des images d'un document à partir des références

à ces images dans le texte d'un document.

Nous

présenterons un premier pas vers un Xquery flexible pour la

recherche d'informations dans des documents semi-structurés :

une integration de Xquery et de NEXI (le langage de requêtes de

INEX), implantée au dessus de Galax.

Vers

l'indexation et le recherche d'images par symboles (Philippe

Mulhem)

De nombreux travaux dans a domaine de l'indexation et

la recherche d'images fixes ou mobiles se sont basés sur des

aspects de bas niveau. Ces travaux ont permis de défricher une

partie de l'énorme difficulté liée à ces

tâches, sans toutefois vraiment résoudre le point

fondamental qui est, comme pour tout système de recherche

d'information, d'aller vers la satisfaction de l'utilisateur. C'est

pour se rapprocher un peu de cet idéal que des travaux

relativement récents (depuis la fin des années 90) se

sont attaqués à réduire le gouffre existant

entre représentation mentale des utilisateurs et

représentation interne de la machine. Ces travaux tentent soit

de représenter les images et requêtes par des structures

représentatives plus abstraites que de simples exemples

visuels, alors que d'autres se basent sur de l'apprentissage pour

définir des descriptions symboliques compréhensibles

directement par l'utilisateur.Nous faisons dans ce cours un survol de

ces approches non-symboliques et symboliques en insistant davantage

sur les travaux sur les images fixes, et nous explicitons certains

verrous scientifiques non encore levés par l'état de

l'art de l'indexation et la recherche d'images.

Programme ERMITES 2006 :

Lundi 4 septembre

14h : Accueil, salle 'Tour Fondue'

Ouverture & présentation des participants

14h45 : Café & boissons & biscuits

15h15-16h15 : S. Bengio (IDIAP), Apprentissage pour le Traitement de Séquences Multimodales

17h-18h30 : P. Gallinari (LIP6), Méthodes statistiques pour l'apprentissage de structures

Rafraîchissements

Pause & Diner

20h30-21h30 : Discussions sur les thèmes 'Apprentissage et RI', Torch, 'Une approche discriminante pour la recherche d'images à partir de requêtes’,…

Mardi 5 septembre

9h-10h : S. Bengio (IDIAP), Recherche d'Information dans les Séquences Multimodales

10h-11h : P. Giraudet (USTV), Neurophysiologie de la Vision : des Traits au Sens

Café, rafraîchissements

11h30-12h30 : P. Mulhem (CLIPS), Indexation & Recherche Sémantique d'Images

Repas

13h30-14h30 : H. Glotin (LSIS), Recherche Robuste d'Information dans des Scènes Audiovisuelles

14h30-15h30 : J. Farinas (IRIT), Identification & Classification Automatique de Langues

15h30-16h30 : J.-F. Bonastre (LIA), Reconnaissance du Locuteur & Indexation de Documents Audio

Café, rafraîchissements

17h-18h : G. Gravier (IRISA), Reconnaissance Automatique de la Parole

Pause et Diner

20h30-21h30 : Discussions sur le thème Transcription Enrichie d'Emissions Radiophoniques (détection parole/musique, suivi et regroupement de locuteur, transcription),…

Mercredi 6 septembre

9h-10h : P. Joly (IRIT), Segmentation & Thématisation de Séquences Vidéo, Similarité de contenu visuel

10h-11h : G. Gravier (& P. Gros) (IRISA), Structuration Multimodale de Vidéos de Sports

Café, rafraîchissements

11h30-12h30 : J. Le Maitre (LSIS), Recherche d'Information Textuelle dans des Documents XML

Repas

14h30-15h30 : Table ronde

16h : Clôture

Café, rafraîchissements

BILAN ERMITES édition 2006

ERMITES 2006 du lundi 4 au mercredi 6 septembre 2006 fut un succès avec 23 participants pour un budget global de 6K€ (inscription tout frais compris à partir de 230 €). Un recueil de 200 pages (en ligne sur le site web) réunit les présentations d'ERMITES06 qui portent sur: théorie de l’information, du signal, des processus aléatoires et de l’apprentissage automatique; l’analyse de scène (audio et vidéo); l’intelligence artificielle; le traitement automatique du langage et de la parole; les sciences cognitives et la neurophysiologie de la perception; la recherche d’information textuelle. Un des objectifs d’ERMITES est que ses participants ne voient plus d’antagonismes entre ces diverses disciplines qui se lieront de plus en plus pour générer des SRIM efficaces. Un ouvrage est en cours de discussion sur le contenu de cette première édition (HERMES).

ERMITES06 a regroupé 23 participants, dont 4 industriels (INA, DCN, OSEAN) :

|

faiza.abbaci@ulb.ac.be (annulation motif personnel) |

Comité de Programme :

Hervé Glotin,

Jacques Le Maitre,

Patrick Gallinari.

Comité d'organisation :

Hervé

Glotin,

Jacques Le Maitre.